فهرست مطالب:

- مرحله 1: موارد مورد نیاز:

- مرحله 2: اصل کار:

- مرحله 3: برداشت و پردازش ورودی:

- مرحله 4:

- مرحله 5:

- مرحله 6: قسمت پردازش:

- مرحله 7:

- مرحله 8:

- مرحله 9:

- مرحله 10:

- مرحله 11:

- مرحله 12: کنترل حرکت:

- مرحله 13:

تصویری: Gesture Hawk: روبات کنترل شده با اشاره با استفاده از رابط کاربری پردازش تصویر: 13 مرحله (همراه با تصاویر)

2024 نویسنده: John Day | [email protected]. آخرین اصلاح شده: 2024-01-30 08:55

Gesture Hawk در TechEvince 4.0 به عنوان یک رابط ساده پردازش تصویر مبتنی بر انسان و ماشین نمایش داده شد. کاربرد آن در این واقعیت نهفته است که هیچ سنسور اضافی یا پوشیدنی به جز دستکش برای کنترل ماشین رباتیک که بر اساس دیفرانسیل درایو کار می کند ، لازم نیست. در این دستورالعمل ، ما شما را با اصل کار پشت ردیابی اشیا و تشخیص حرکات مورد استفاده در سیستم آشنا می کنیم. کد منبع این پروژه را می توانید از Github از طریق پیوند بارگیری کنید:

مرحله 1: موارد مورد نیاز:

- درایور موتور L298N

- موتورهای DC

- شاسی ماشین روبات

- آردوینو اونو

- باتری های LiPo

- کابل USB آردوینو (بلند)

- کتابخانه OpenCV با پایتون

مرحله 2: اصل کار:

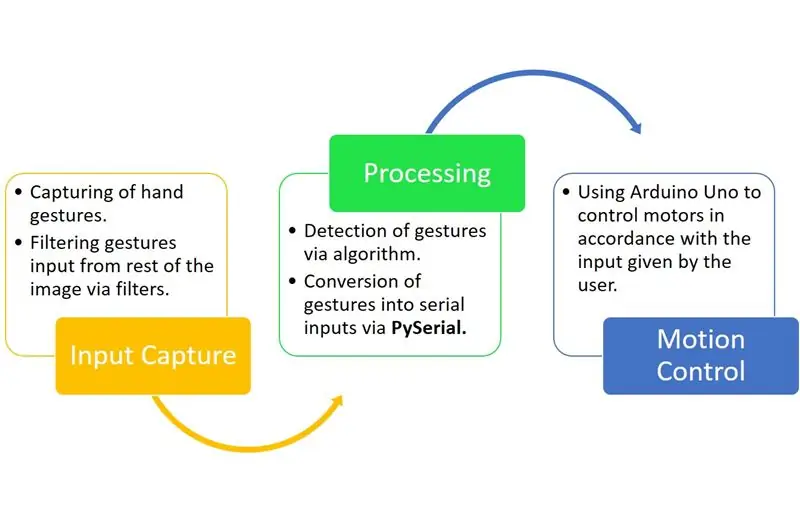

همانطور که در نمودار بالا مشاهده می کنید ، Gesture Hawk یک سیستم پردازش سه فاز است.

مرحله 3: برداشت و پردازش ورودی:

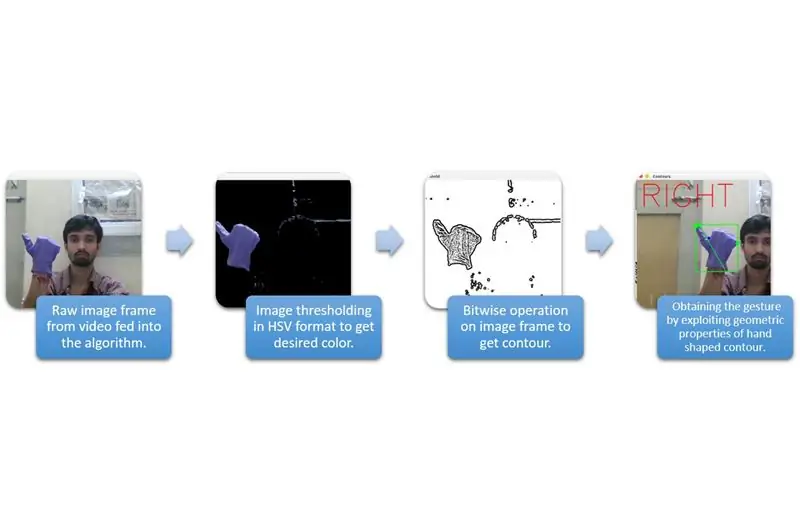

ضبط ورودی را می توان در دسته های گسترده تری که در نمودار بالا ذکر شده است ، درک کرد.

برای استخراج شکل دست از محیط ، باید از ماسک یا فیلتر یک رنگ مشخص (در این مورد - آبی بنفش) استفاده کنیم. برای انجام این کار ، باید تصویر را از فرمت BGR به HSV تبدیل کنید که می تواند با استفاده از قطعه کد زیر انجام شود.

hsv = cv2.cvtColor (قاب ، cv2. COLOR_BGR2HSV)

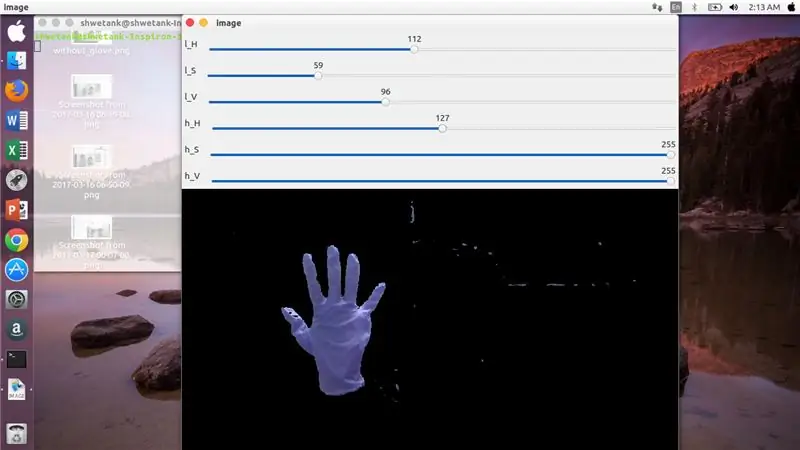

اکنون ، قدم بعدی این است که محدوده موردنظر از پارامترهای HSV را برای بیرون کشیدن دست از طریق ماسک یا فیلتر پیدا کنید. برای این منظور ، بهترین راه استفاده از میله های آهنگ برای یافتن محدوده مناسب است. در اینجا تصویر صفحه نوار آهنگ مورد استفاده برای این پروژه را مشاهده می کنید.

مرحله 4:

مرحله 5:

در اینجا ، یک قطعه کد در زیر برای ایجاد چنین نوار آهنگ برای ساخت ماسک آمده است:

واردات cv2

وارد کردن numpy به عنوان npdef هیچ چیز (x): گذر cv2.namedWindow ('image') img = cv2. VideoCapture (0) cv2.createTrackbar ('l_H'، 'image'، 110، 255، something) cv2.createTrackbar ('l_S '،' image '، 50، 255، nothing) cv2.createTrackbar (' l_V '،' image '، 50، 255، nothing) cv2.createTrackbar (' h_H '،' image '، 130، 255، nothing) cv2. createTrackbar ('h_S'، 'image'، 255، 255، nothing) cv2.createTrackbar ('h_V'، 'image'، 255، 255، nothing) while (1): _، frame = img.read ()

hsv = cv2.cvtColor (frame، cv2. COLOR_BGR2HSV) lH = cv2.getTrackbarPos ('l_H'، 'image') lS = cv2.getTrackbarPos ('l_S'، 'image') lV = cv2.getTrackbarPos ('l_V'، 'image') hH = cv2.getTrackbarPos ('h_H'، 'image') hS = cv2.getTrackbarPos ('h_S'، 'image') hV = cv2.getTrackbarPos ('h_V'، 'image') lower_R = np آرایه ([lH، lS، lV]) above_R = np.array ([hH، hS، hV]) mask = cv2.inRange (hsv، lower_R، above_R) res = cv2.bitwise_and (قاب ، قاب ، ماسک = ماسک) cv2.imshow ('image'، res) k = cv2.waitKey (1) & 0xFF if k == 27: break cv2.destroyAllWindows ()

مرحله 6: قسمت پردازش:

خوب ، ما شکل هندسی یک دست را داریم ، اکنون زمان استفاده از آن و استفاده از آن برای تشخیص حرکت دست است.

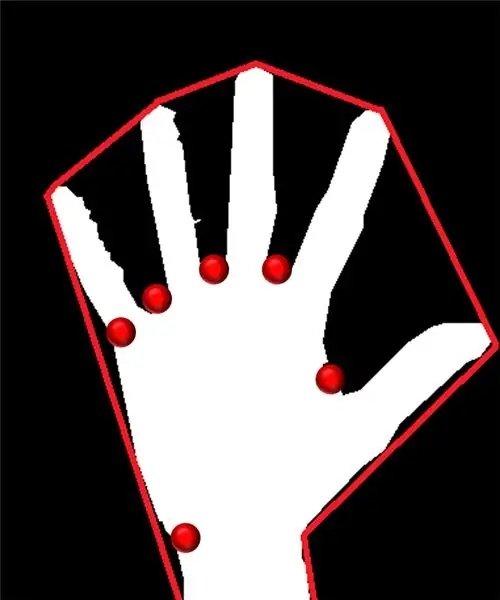

بدنه محدب:

از طریق بدنه محدب ، ما سعی می کنیم چند ضلعی تقریبی را از طریق نقاط شدید موجود در شکل متناسب کنیم. تصویر موجود در سمت چپ چند ضلعی تقریبی را نشان می دهد که به شکل با نقاط محدب با قرمز مشخص شده است.

نقاط محدب آن نقاطی هستند که از نظر شکل از هم دورتر از یک ضلعی هستند. اما ، مشکل بدنه محدب این است که در حین محاسبه آن ، ما یک آرایه از تمام نقاط محدب دریافت می کنیم ، اما آنچه ما نیاز داریم نقطه محدب نوک تیز آبی است. ما به شما خواهیم گفت که چرا مورد نیاز است.

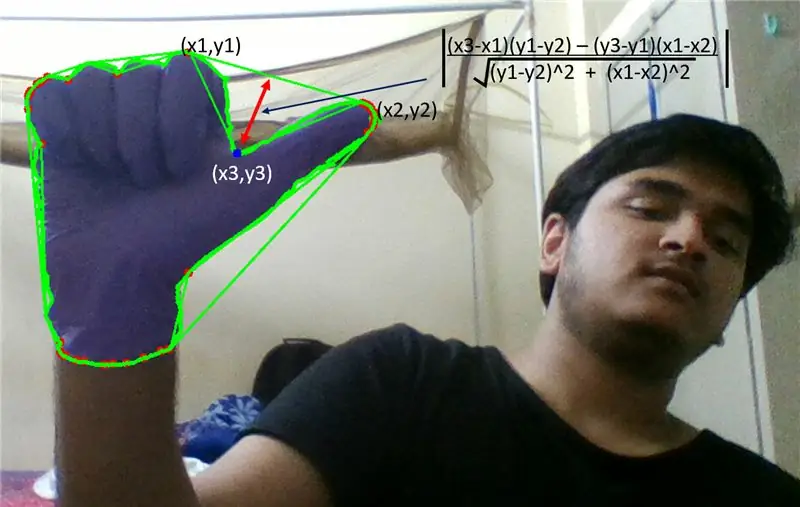

برای یافتن این نقطه محدب ، ما باید فرمول عمود بر فاصله را برای یافتن فاصله نقطه محدب با نزدیکترین طرف اعمال کنیم. ما مشاهده کردیم که نقطه نوک آبی دارای حداکثر فاصله از طرف است و بنابراین ما این نقطه را بدست می آوریم.

مرحله 7:

مرحله 8:

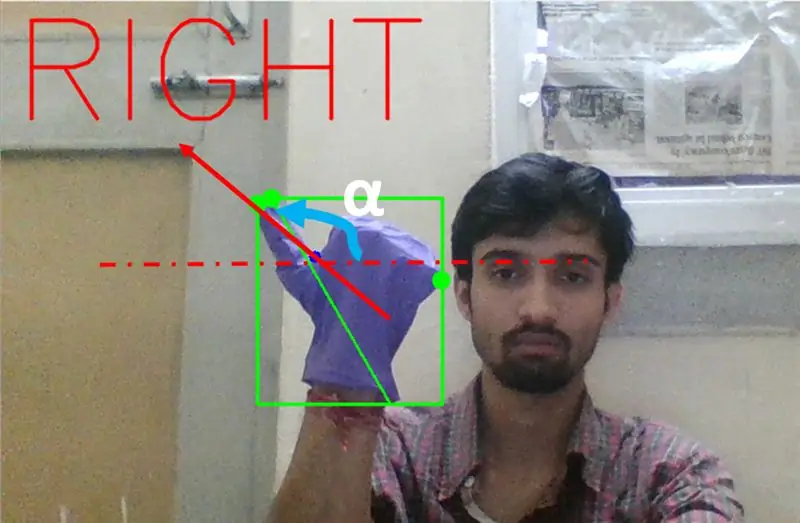

در مرحله بعد ما باید شیب خطی را که به نوک انگشت شست (یا نقطه شدید) به این نقطه محدب با افقی متصل می شود ، پیدا کنیم.

مرحله 9:

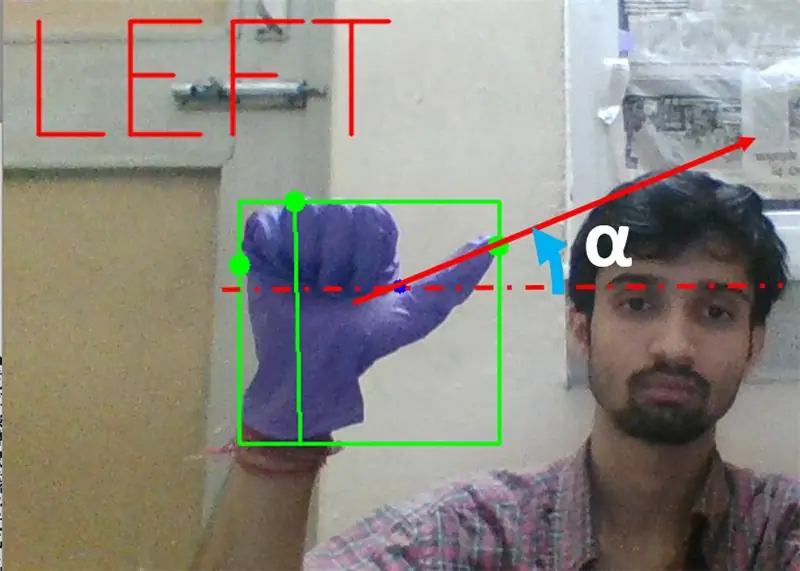

در حالت فوق ، اگر حرکت برای چرخش به چپ باشد ، باید زاویه α بین 0 تا 90 درجه باشد. یعنی برنزه (α) باید مثبت باشد.

مرحله 10:

در حالت بالا ، اگر حرکت برای چرخش راست باشد ، باید زاویه α بین 180 تا 90 درجه باشد. یعنی برنزه (α) باید منفی باشد.

بنابراین ، اگر Tan α مثبت است ، سپس به چپ بپیچید. اگر Tan α منفی است ، سپس به راست بپیچید. اکنون وقت آن است که ببینیم چگونه می توان مهمترین دستور توقف را تشخیص داد.

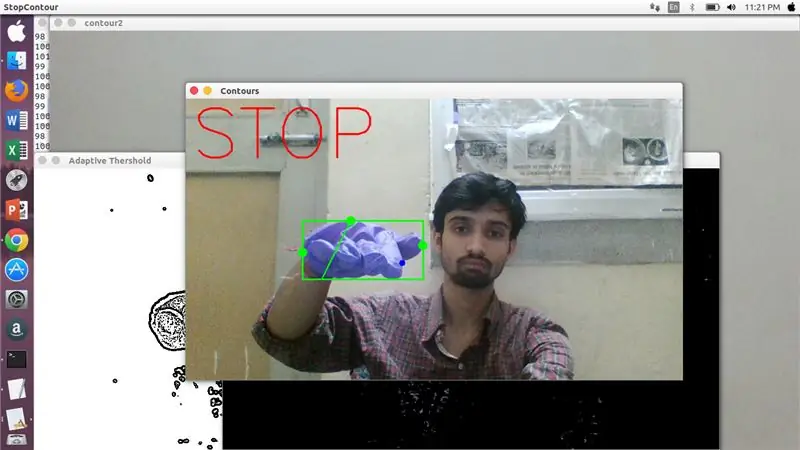

در اینجا ، یک نسبت مشخص شده (با ضربه و آزمایش یافت می شود) مورد بررسی قرار می گیرد و در بیشتر موارد این نسبت فاصله ها در این محدوده خاص باقی می ماند.

مرحله 11:

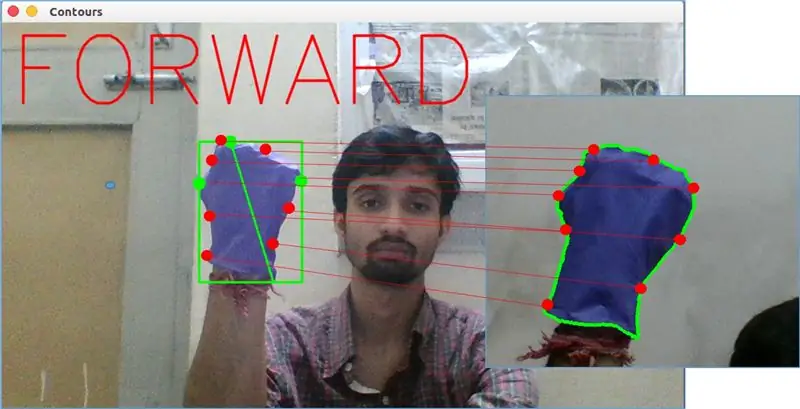

در نهایت ، حرکت جلو به وسیله تابع matchShape () در OpenCV مورد تجزیه و تحلیل قرار می گیرد. این عملکرد ، شکل دو شمارنده را مقایسه می کند ، در این مورد ، بین مثال تمرین در thight در تصویر بالا با خط در سمت چپ تصویر بالا. با توجه به تغییرات موجود در شکل دو خط ، مقداری از 0 تا 2 یا 3 را باز می گرداند. برای همان کانتور ، 0 را برمی گرداند.

ret = cv2.match شکل (cnt1 ، cnt2 ، 1 ، 0.0)

در اینجا ، cn1 و cnt2 دو کانتور هستند که باید مقایسه شوند.

مرحله 12: کنترل حرکت:

PySerial:

ما از کتابخانه PySerial python برای تبدیل داده های پردازش شده به داده های سریال برای ارتباط با Arduino Uno از طریق کابل USB Arduino استفاده کردیم. هنگامی که یک حرکت خاص توسط opencv تشخیص داده شد ، یک متغیر موقتی به نام 'x' ایجاد کردیم و مقدار منحصر به فردی به آن اختصاص دادیم و آن را با استفاده از خط فرمان زیر به ورودی سریال تبدیل کردیم:

وارد کردن سریال #برای وارد کردن کتابخانه Pyserial

serial. Serial (''، baudrate = '9600'، timeout = '0') # تنظیم خروجی سریال.. PORT NAME نام پورتی است که انتقال داده ها توسط آن انجام می شود.

serial.write (b'x ') # x الفبایی است که به پورت ارسال می شود … b برای تبدیل این رشته به بایت است.

پردازش آردوینو:

اکنون آردوینو به گونه ای کدگذاری شده است که هر سری x متفاوت به صورت خطی برای یک عمل خاص که مسئول حرکت روان روبات است ترسیم می شود (به عنوان مثال تشخیص حرکت چپ باعث می شود موتورهای سمت راست به چپ بپیچند). ما می توانیم حرکت هر چرخ را به صورت ترجمه و همچنین چرخشی با تغییر صحیح کد کنترل کنیم.

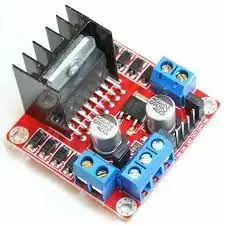

L298N راننده موتور:-

درایور موتور به عنوان واسطه بین موتور و منبع تغذیه استفاده می شود زیرا موتورها به دلیل ولتاژ پایین نمی توانند مستقیماً تغذیه شوند. باتری Li-Po به ترمینال ورودی 12 ولت آن متصل است و ما سوکت 5 ولت arduino را به سوکت ورودی 5 ولت راننده موتور وصل می کنیم و سرانجام زمین Li-Po و همچنین arduino را در یک سوکت زمین مشترک راننده موتور متصل می کنیم.

اکنون پایانه های موتورها در پریزهای داده شده متصل می شوند. در نهایت ما پایانه های ورودی موتور را به سوکت های خروجی PWM آردوینو متصل می کنیم که به ما این امکان را می دهد تا جنبه های چرخشی و ترجمه ای حرکت را به طور دقیق تعیین کنیم.

توصیه شده:

ربات کنترل شده با اشاره با استفاده از آردوینو: 7 مرحله

ربات کنترل شده با اشاره با استفاده از آردوینو: روبات ها در بسیاری از بخشها مانند ساخت و ساز ، نظامی ، ساخت ، مونتاژ و غیره استفاده می شوند. روبات ها می توانند مستقل یا نیمه خود مختار باشند. روبات های خودران نیازی به دخالت انسان ندارند و می توانند به تنهایی با توجه به شرایط عمل کنند. سه

پردازش تصویر با Raspberry Pi: نصب OpenCV و جداسازی رنگ تصویر: 4 مرحله

پردازش تصویر با Raspberry Pi: نصب OpenCV و جداسازی رنگ تصویر: این پست اولین مورد از چندین آموزش پردازش تصویر است که باید دنبال شود. ما نگاهی دقیق تر به پیکسل های تشکیل دهنده یک تصویر می اندازیم ، نحوه نصب OpenCV بر روی رزبری پای را یاد می گیریم و همچنین اسکریپت های آزمایشی را برای ثبت یک تصویر و همچنین آموزش

ربات SCARA: یادگیری درباره سینماتیک دور و معکوس !!! (Plot Twist بیاموزید که چگونه با استفاده از پردازش یک رابط زمان واقعی در ARDUINO بسازید !!!!): 5 مرحله (همراه با تصاویر)

ربات SCARA: یادگیری درباره سینماتیک دور و معکوس !!! (Plot Twist بیاموزید که چگونه با استفاده از پردازش یک رابط زمان واقعی در ARDUINO بسازید !!!!): یک ربات SCARA یک ماشین بسیار محبوب در جهان صنعت است. این نام مخفف هر دو بازوی روبات انتخابی سازگار مجمع یا بازوی ربات مفصل انتخابی است. این در اصل یک ربات آزادی سه درجه ای است که دو مورد اول است

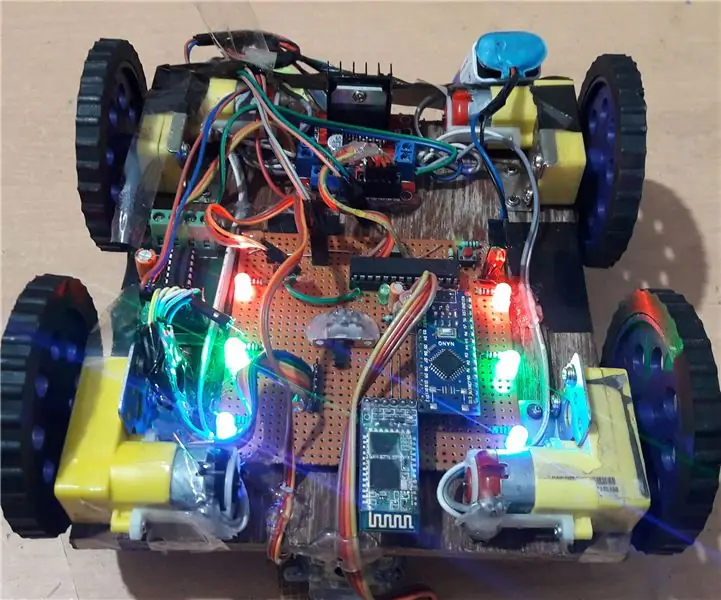

ساخت ربات کنترل شده با بلوتوث با رابط کاربری گرافیکی شخصی خود: 5 مرحله

با رابط کاربری گرافیکی خود یک ربات کنترل شده با بلوتوث بسازید: سلام به دوستان ، پس از ارائه یک پروژه صنایع دستی امروز ، من با یک پروژه آردوینو جالب آشنا شدم. به نظر می رسد از نظر ظاهری قدیمی است ، اما بچه ها منتظر بمانید ، من اینجا پیچ و تاب هایی دارم که این پروژه را منحصر به فرد می کند. بنابراین اینجا چه چیزی منحصر به فرد است؟ بنابراین در اینجا من قصد دارم به شما نشان دهم

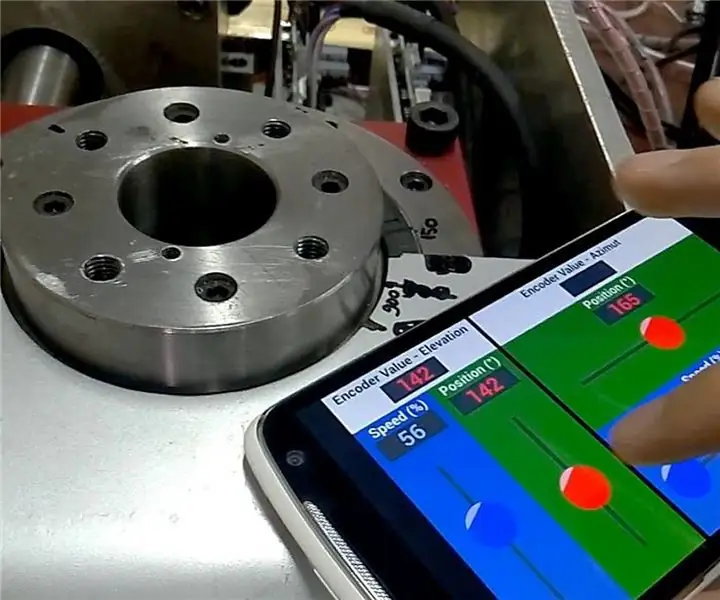

رابط کاربری Android (remotexy) برای کنترل موتور سروو با استفاده از آردوینو و بلوتوث: 7 مرحله (همراه با تصاویر)

رابط کاربری Android (remotexy) برای کنترل موتور سروو با استفاده از آردوینو و بلوتوث: در این دستورالعمل سریع به شما این امکان را می دهم تا رابط کاربری Android را با استفاده از Remotexy Interface Maker برای کنترل سرو موتور متصل به Arduino Mega از طریق بلوتوث انجام دهید. این ویدئو نشان می دهد که چگونه UI سرعت و موقعیت سرو موتور را کنترل می کند